欢迎您访问广东某某机械环保科有限公司网站,公司主营某某机械、某某设备、某某模具等产品!

全国咨询热线: 400-123-4567

新闻资讯

新闻资讯 哈希游戏| 哈希游戏平台| 哈希游戏官方网站

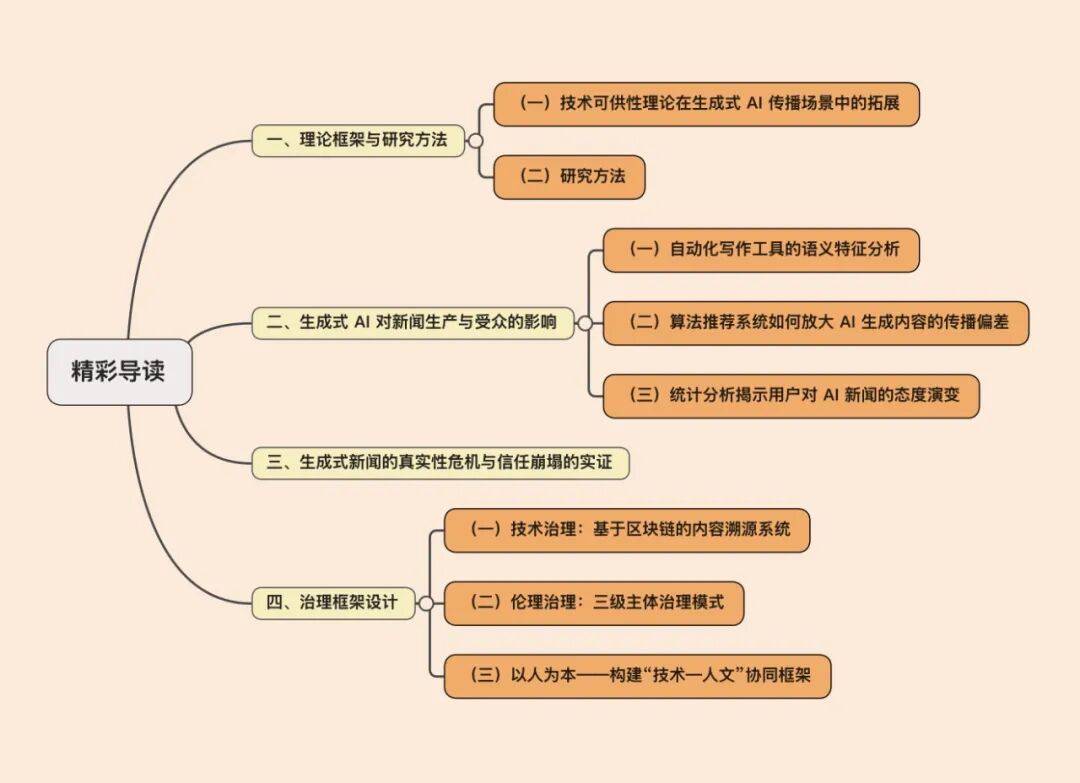

哈希游戏| 哈希游戏平台| 哈希游戏官方网站哈希游戏- 哈希游戏平台- 哈希游戏官方网站文章以技术可供性理论在生成式AI传播场景中的拓展与应用为理论基础,解析AIGC为新闻生产、分发与消费环节带来的新型行动可能性及其潜在危机。主要采用定量的统计分析方法,通过对大规模AI生成新闻文本语料库的系统性挖掘与计算,重点围绕三个核心维度展开:生成式AI新闻的语义特征、算法偏差对新闻传播的结构性影响,以及受众对AI 新闻认知态度与接受程度的动态转变规律及其影响因素。基于实证分析所揭示的关键风险与挑战,文章提出系统性应对策略。在技术层面,创新性地构建了基于区块链分布式账本技术的内容溯源验证系统,旨在为AI生成新闻建立可验证、不可篡改的来源与传播轨迹记录。在伦理层面,提出“开发平台—媒体机构—公众”三级主体协同治理模式,以形成透明、可追溯、权责明晰的内容生态治理框架。同时设计了以人为本的“技术—人文”协同框架,强调技术应用必须始终服务于新闻传播的公共性、真实性核心价值与社会责任,将人的价值、尊严及对真相的判断力置于核心地位。

人工智能生成内容(AIGC)的迅猛发展正重塑新闻传播领域的底层逻辑与实践[1]。作为新闻传播学者,既需要理解技术演进的内在规律,也必须清醒认识由此引发的系统性变革。从技术演进轨迹观察,生成式AI已实现从单一模态到多模态协同的跨越式发展(从文本到图像、视频等)。Transformer架构的突破使大语言模型的参数规模从GPT-3的1750亿激增至GPT-4的约1.8万亿,语义理解准确率显著提升。扩散模型推动视觉生成拥有专业级水准,如用户对MidJourney生成的图像满意度很高,而Sora模型更实现了快速的高质量视频的端到端生成。技术跃迁直接重构了新闻生产模式,实现了新闻生产效率的大幅提升。

AI生成新闻导致的信息模糊性对新闻伦理形成挑战。如深度伪造技术使虚假信息检测准确率下降,算法偏见在选举报道中造成了部分立场偏移,而AIGC的规模化生产更使信息溯源难度显著提高[2]。现有伦理框架在责任归属划定上存在明显缺陷,责任应在算法开发者、媒体机构还是监管主体?欧盟《数字服务法案》要求平台开放算法黑箱,但执行率不高;区块链技术的应用虽在某种程度上实现了内容溯源,但跨平台协同仍存在技术壁垒[3]。

生成式AI通过算法、算力、数据的深度融合,突破了传统新闻生产的物理性限制。一方面,其能自动化生产内容。AI依托自然语言处理和深度学习,实现财经、体育等结构化领域新闻的自动生成(如《》的财经播客“The Daily”),将记者从基础写作中解放,转向深度调查与解释性报道。另一方面,其还能实现多模态融合。以Sora为代表的文生视频技术,通过海量视频数据训练,能够快速模拟新闻现场或历史场景,增强报道的沉浸感(如央视冬奥会虚拟机器人报道)。这类技术可供性不仅提高了效率,更重构了新闻叙事的形态[5]。

生成式AI重塑了用户对新闻的感知方式,同时也引发了对新闻传播的信任危机。基于用户特征的AI推荐系统(如字节跳动的算法分发)虽提高了信息匹配效率,但也可能影响公众对多元议题的认知,形成个性化信息茧房[7]。同时,还会对新闻真实性形成伦理挑战,AI生成内容的逼真性(如Deepfake视频)削弱了用户对媒介的天然警惕,也迫使可信度评估从内容真实性转向技术可追溯性。例如,法新社的InVID工具通过验证元数据打击虚假新闻,体现了技术可供性在对抗“后真相”中的双重作用。

使用TF-IDF和LDA方法对生成式AI实现的新闻内容进行语义特征分析。以科技新闻为例,本研究对比了200篇AI生成的新闻与200篇人类记者撰写的同类文本。结果显示,AI文本高频词集中于通用技术术语(如“人工智能”“算法”),而人类文本更多包含行业专有名词(如“卷积神经网络”“机器学习”),这表明 AI 内容偏向泛化表达。主题模型进一步揭示,AI文本的主题分布集中(内容聚焦几个核心主题),而人类文本主题多样,且包含更多批判性视角(如“伦理争议”“技术垄断”)。这种差异源于AI依赖训练数据的统计规律,而人类记者通过专业判断筛选信息。

算法推荐系统通过用户行为数据优化内容分发,但可能系统性放大AI生成内容的传播偏差。AI生成的娱乐新闻因标题吸引力强(如“明星隐私泄露事件”)、情感极性显著,其点击率较人工撰写的新闻高,触发平台算法将其优先推荐至流量池。但是这种机制造成了两大问题:一是信息窄化,AI生产的同质化内容通过协同过滤算法形成“回音壁效应”,如气候变化的AI报道集中于极端天气描述,而政策讨论类内容曝光量下降;二是真实性不足,AI生成的虚假信息因符合用户认知框架(如阴谋论叙事),传播速度更快,麻省理工学院的实验显示,虚假AI新闻的转发量比真实新闻多。

情感分析显示,AI运用初期呈现正面情绪,涉及“报道速度”“多模态呈现”等关键词的评论占比较大。例如,生成式AI在北京冬奥会中被广泛应用于内容生成、赛事分析和观众互动等领域,显著提升了效率和体验。北京冬奥会期间,AI技术通过高效内容生成和多模态交互显著提升了公众体验。赛事中部署的AI裁判系统利用高速摄像头与深度学习算法实时捕捉运动员动作细节,不仅确保判罚准确,还将精彩瞬间生成即时分析视频。用户惊叹“机器人记者能比人类更快捕捉精彩瞬间”,凸显出对报道的认可。同时,多模态呈现技术打破感官边界,央视与百度联合推出的“AI手语主播”通过自然动作引擎驱动虚拟形象,为2700万听障用户提供精准赛事解说。这一阶段,大众主要表现出新技术对效率提高的乐观情绪。

在涉及俄乌冲突的AI生成战况模拟视频讨论中,公众焦虑情绪显著升高。例如,俄军被曝利用AI技术伪造“单日歼敌1305人”的虚拟战果视频,通过混合真实战场画面(如控制顿涅茨克定居点)增强迷惑性,这类内容在TikTok等平台扩散后,因视觉冲击力强且算法精准推送,引发东欧地区用户对战争规模扩大的恐慌。与此同时,深度伪造技术的滥用进一步加剧了社会焦虑。2024年,有商家截取张伯礼院士公开演讲素材,利用开源AI工具生成虚假护肤品宣传视频,并通过短视频平台定向推送给中老年群体;同年,韩国曝出大规模深度伪造色情犯罪,犯罪者将女性(含未成年人)面部合成至不雅视频中,并通过媒体群组传播。这些案例引发了民众的信任危机。

当前,学术界对生成式AI展开价值理性批判,研究认为生成式AI新闻造成了对新闻真实性本质的消解,易因语料偏见或算法缺陷导致虚假信息泛滥[8],其合成能力(如Sora生成的仿真视频)模糊了真实与虚构的边界,直接冲击了新闻真实性的伦理根基,还会导致专业主体性弱化,AI自动化写作挤压新闻从业者的创作空间,技术工具化导向导致“人机主客关系”失衡。研究者指出,过度依赖AI可能使记者沦为技术附庸,削弱其深度调查与价值判断能力,甚至威胁职业认同[9]。同时,其可能导致工具理性对公共价值的异化,生成式AI以效率为导向的“流量逻辑”可能扭曲新闻的社会服务属性。研究者批评,过度追求传播效果易导致浅层化内容激增,消解媒体的公共监督与文化引导功能。

CNN在2025年1月的报道中指出,苹果公司推出的“新闻摘要”功能因多次生成并推送错误新闻标题,引发全球范围内的信任危机。这一事件揭示了生成式AI技术在新闻传播中的潜在风险,缺乏人工审核的自动化流程导致虚假信息以“权威推送”形式快速扩散,不仅损害了媒体的公信力,更动摇了公众对技术可靠性的信任基础。该功能通过大语言模型对新闻内容进行自动摘要,生成与常规推送通知高度相似的标题。例如,AI曾错误总结《》文章,宣称“以色列总理本雅明·内塔尼亚胡已被捕”;另一次则将BBC关于谋杀案的报道曲解为“嫌疑人开枪自杀”。

例如,2024年2月,广州互联网法院判决了全球首例生成式AI服务侵犯著作权的案件。某人工智能公司未经授权,利用受版权保护的“奥特曼”系列形象训练其AI模型,并通过付费服务生成与原创作品实质性相似的图片。区块链溯源系统记录显示,该公司模型训练数据中包含了未经许可的奥特曼形象数据集哈希值。法院最终判定其侵犯复制权和改编权,要求下架所有侵权内容并赔偿损失。这一案例凸显了区块链溯源技术在内容合规审查中的关键作用。

技术开发者处于责任链的初始环节,其首要义务在于确保模型训练数据的公平性与算法决策的可解释性。研究表明,算法歧视与偏见主要源于历史数据的偏差继承与放大,如GPT-3成内容重复了训练数据内隐含的种族和性别刻板印象,此类系统性偏见需通过语料库清洗与算法审计来修正。在我国,《生成式人工智能服务安全基本要求》(2024)明确要求开发者对训练数据来源进行合法性审核,并通过风险证据保留机制实现全周期追溯。典型案例可参考谷歌Gemini模型因过度矫正导致种族表征失真的案例,该事件暴露出开发者在道德与事实遵循之间的平衡困境,凸显出算法透明度的必要性。

传播主体在算法部署阶段承担二级审核责任,需依据内容风险等级设置差异化人工介入规则。实证研究表明,很多AI生成政治新闻存在隐性立场偏向,这要求媒体机构建立分类审核机制:对时政类报道实施100%人工复核,而娱乐资讯可将阈值放宽。风险社会理论认为这种阈限管理能有效平衡传播效率与伦理安全,防止算法黑箱导致责任线]。媒体机构作为部署者,需设置人工审核节点确保内容线年欧盟通过的《人工智能法案》规定,机构若未履行审核义务,罚款最高可达3500万欧元或上一财年年收入的7%。该法案还强调,媒体需对AI生成内容进行标识,并提供用户申诉渠道,以提高透明度。

[11]。协同框架还需将记者专业判断作为算法约束参数,将新闻伦理准则(如平衡报道、信源交叉验证)转化为算法约束参数,限制AI生成内容的结构与倾向[12],并在AI生成内容的反馈环节中插入多源数据验证机制,如自动对比权威数据库(如政府公开数据、学术界报告),触发异常标记。协同框架要坚持以人为本的基本原则,强调人类是最终责任主体,在技术与人类主体之间保持平衡,使AI新闻始终以服务人类福祉为核心,避免技术异化导致的人文精神弱化。